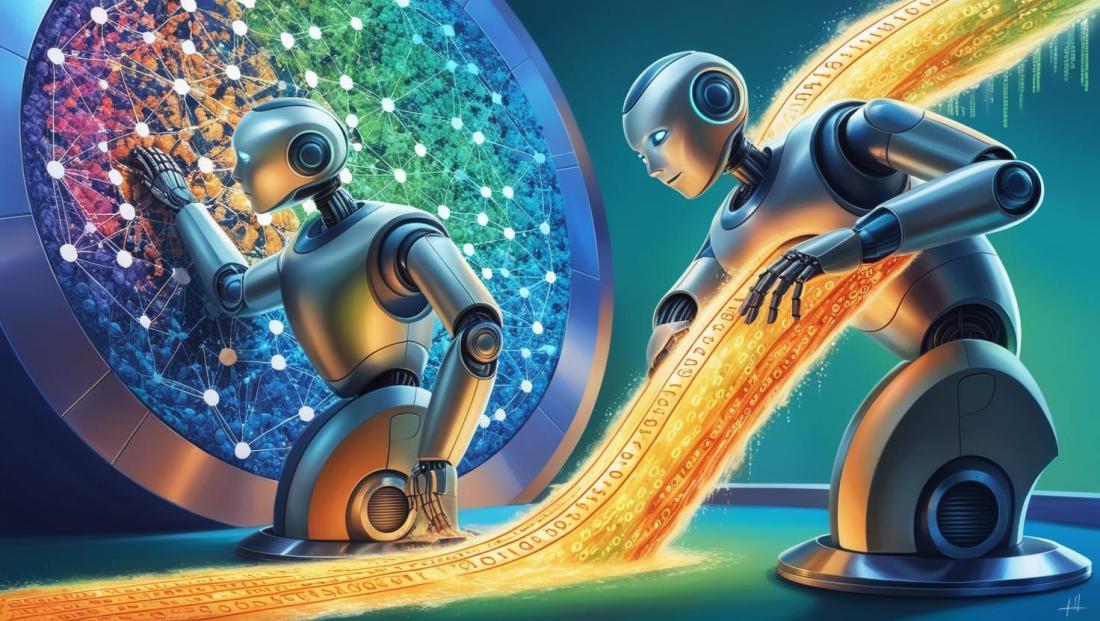

Após um avanço no qual nos afastamos das visões apocalípticas e sinais de fumaça projetados para distrair o menos versado, em nossa primeira visão geral desse tipo de tecnologias, continuaremos a colocar um contexto do uso dessas ferramentas úteis da IA como uma aplicação útil para os problemas que já tivemos, e até mesmo que possamos considerar graças ao poder, e a abordagem de abordagem diferente.

E é que a IA, como um conceito mais do que genérico, mas antes de tudo as múltiplas tecnologias e técnicas que incluem se tornar uns elementos fundamentais no tratamento atual e futuro dos modelos de dados, desde os níveis iniciais de ingestão, até sua exploração nos últimos níveis de análise e exposição.

Se falarmos sobre dados, nos últimos anos a frase já desgastada "Os dados são o novo petróleo" cunhados pelo matemático britânico Clive Humby, em 2006, isso nos leva inexoravelmente à necessidade de ter processos complexos para seu tratamento e refinaram -se para obter as informações desejadas e o consequente conhecimento desejado que eles contêm no poder. Isso nos leva a reflexões muito mais antigas, como a frase repetida "conhecimento é poder" popularizado por Thomas Hobbes em meados do século XVII, e abordagens mais atuais que resultaram em projetos complexos que a IA é chamada para otimizar, graças a ferramentas com uma abordagem muito diferente da tradicional.

Uma série de problemas a serem resolvidos que transformaram as diferentes facetas da IA em uma caixa de ferramentas obrigatória

E é que o tratamento de enormes (e cada vez mais crescentes volumes) de informação, sua heterogeneidade, os problemas em torno da qualidade e integridade do mesmo ... vêm colocando na mesa nos últimos anos, uma série de problemas a serem resolvidos que transformaram as diferentes facetas da IA em uma caixa de ferramenta de aplicação forçada em projetos de calibre e complexidade. Ao longo deste artigo, veremos, com algumas áreas como exemplo, como a IA pode nos ajudar nos projetos de processamento de dados e que já estamos nos inscrevendo no dia a dia (deixaremos as visões mais futuristas para as próximas parcelas).

Integração e limpeza de dados

Estas tecnologias são aplicáveis desde as primeiras fases do tratamento de dados nos nossos projectos. A própria ingestão de informação pode beneficiar ao permitir o tratamento, por exemplo, de dados não estruturados (que tradicionalmente permaneciam em áreas obscuras ou dependiam de um subconjunto de metadados) utilizando o processamento de linguagem natural (PNL). Isto permite-nos normalizar estes documentos de origem, pdfs e ficheiros Office, obtendo deles informações que podem ser classificadas e analisadas em fases subsequentes dos nossos processos de transformação e processamento.

Também torna mais benigna a fastidiosa tarefa de limpeza dos dados. A seleção manual de alternativas, ou os processos pseudo-manuais de reafectação e limpeza de dados por substituição, podem ser apoiados por algoritmos de imputação de dados (mais ou menos automatizados) que permitem atribuir valores prováveis ou esperados aos dados em falta (ou aos dados que se detetam como manifestamente incorretos). Técnicas como o K-Nearest Neighbors (KNN) encontram valores semelhantes ou comparáveis noutros registos “próximos” do registo com os dados em falta que estamos a processar, ou abordagens mais complexas e iterativas como o algoritmo MICE.

É comum encontrar dados em falta ou incoerentes nas nossas fontes de dados. Por exemplo, num conjunto de dados de recenseamento em que a idade, a morada ou o estado civil do cidadão não correspondem ao que se espera, ou não são corretamente comunicados. Estes algoritmos de imputação de dados em falta permitem-nos atribuir valores esperados de acordo com o comportamento de cidadãos mais semelhantes com base na localização, rendimento ou composição familiar, ou simplesmente facilitar a deteção de valores em falta, ou mesmo de valores potencialmente mais inconsistentes, notificando os gestores responsáveis pelo processamento para revisão manual.

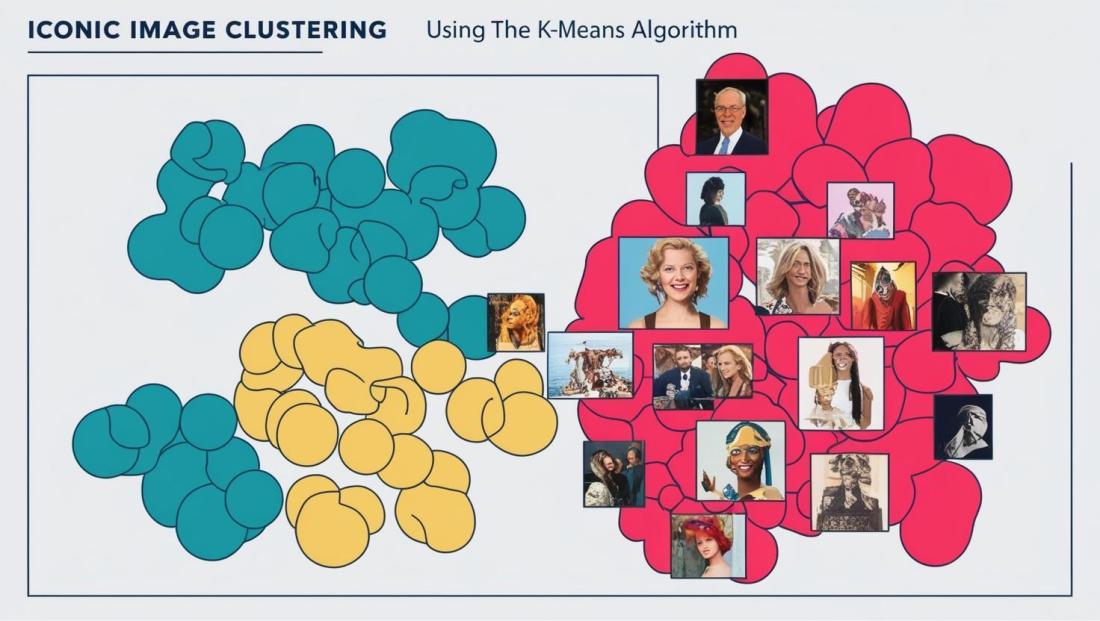

Classificação e segmentação da informação

Quando tratamos a informação, um elemento-chave é poder classificá-la em torno de certos valores ou caraterísticas. Tradicionalmente, estas segmentações eram prefixadas e, em seguida, utilizando procedimentos pesados, os dados eram tratados a um nível baixo para identificar e localizar cada uma delas de acordo com as suas propriedades e comportamentos.

Para a detecção desses padrões, temos técnicas de agrupamento clássicas, mais conhecidas como algoritmos de "clustering", como K-Means ou DBSSCAN. Estes são baseados principalmente na "organização" dos valores de uma determinada dimensão, com base em várias medidas de análise e no cálculo das distâncias entre cada um desses valores, ou diretamente a densidade deles. Isso permite, agrupar e estabelecer grupos, ou segmentos que permitem o cálculo dessas dimensões de acordo com novos critérios de classificação associados ao seu comportamento.

Esses algoritmos são amplamente aplicáveis e aplicados, quando tivermos dados estruturados, no caso de trabalhar com aqueles não estruturados, outras técnicas são adicionadas a outras técnicas para poder torná-las assumidas a um processo de segmentação. Assim, por exemplo, em um processo de classificação de documentos legais, podemos aplicar técnicas de vectorização de texto, como incorporação de TF-IDF ou word embeddings, que servem como base dos processos de segmentação subsequentes suportados por esses vetores.

Essas técnicas também podem ser aplicadas, não apenas para classificar, mas também para detectar padrões anômalos ou que não correspondem aos comportamentos esperados ou dentro de uma certa norma. Assim, sendo aplicável ao controle de fraudes ou detecção de populações com certos riscos.

Assim, numa hipotética estratégia de cobrança de impostos, tais algoritmos podem ser aplicados com base em dados como o histórico de pagamentos, o nível de rendimentos e até o consumo de outros serviços municipais, permitindo gerar perfis diferenciados que classifiquem o nível de risco de incumprimento, ou até mesmo os grupos de utilizadores que, como grandes consumidores de serviços (e, portanto, pagadores), requerem um tratamento específico da nossa parte.

Securização de dados

Sempre que lidamos com dados, e é importante sublinhar o “sempre”, embora haja contextos em que também é obrigatório, a segurança dos dados no seu tratamento deve ser uma máxima que nos deve guiar e que não podemos perder de vista.

Numa primeira instância, a IA pode ajudar-nos em todos os nossos processos de encriptação e ofuscação de informação, quando temos de a passar entre a limpeza e estruturação até à predição e tomada de decisão automatizada, os algoritmos de IA estão a transformar a forma como trabalhamos a informação.

Descubra como a Inteligência Artificial está a ser aplicada a diferentes processos de transformação, por vezes externalizados. Apoiando-nos em sistemas de cifragem dinâmica, podemos proteger os dados sensíveis tanto do acesso dos seres humanos, de acordo com o seu nível de acesso, como do acesso dos processos tecnológicos que têm acesso ao conjunto de dados num determinado momento (e estes processos podem ser outras IA, que estamos a normalizar excessivamente ao emprestar informações a máquinas sem as reflexões adequadas...).

Encriptação de dados estruturados, bem como ofuscação e ocultação de determinadas informações em documentos eletrônicos em formatos como o pdf, para que o acesso não ponha em causa a proteção de parte da informação neles contida, que por sua vez pode ser localizada automaticamente, sem que a sua localização seja previamente conhecida, através de técnicas de OCR e de processamento de linguagem natural (PNL).

Também apoia a deteção de acessos suspeitos. Analisando os dados de auditoria de acesso, por exemplo, e aplicando redes neuronais profundas (deep learning), podemos distinguir, ou melhor, o nosso sistema pode aprender a distinguir, entre comportamentos normais e comportamentos potencialmente maliciosos, como ataques de phishing, malware ou negação de serviço.

Previsão de tendências e modelação preditiva

Uma das questões estratégicas que acabamos por abordar num momento ou outro, como parte da melhoria da nossa estratégia baseada em dados, é tentar prever o comportamento futuro e, consequentemente, as necessidades associadas, de modo a podermos antecipar tudo o que é necessário para podermos fornecer cobertura da forma mais eficiente possível.

Sobre as nossas séries históricas de dados podemos aplicar técnicas como a regressão linear, que nos permite inferir dados desconhecidos, e a aplicabilidade futura neste espaço, com base em cenários passados de que já conhecemos os resultados, com variáveis que, embora possam não ser as mesmas, têm uma certa dependência ou relação com as que queremos observar. Para além destas, existem outras como as árvores de decisão, com casuística mais ou menos prefixada e outras ainda mais complexas como as redes neuronais que, aplicadas a factos sobre séries temporais, permitem estabelecer cenários preditivos através da transmissão de informação entre as suas camadas.

Aplicando estas técnicas, sobre volumes significativos de dados, combinando tendências de pedidos de dados anteriores com evoluções de indicadores sociodemográficos, podem ser estabelecidos modelos para otimizar os recursos de uma dada atividade. Assim, podemos decidir a nossa estratégia geral de cuidados sociais, com base em modelos preditivos que antecipam em que locais devemos alargar a cobertura dos nossos centros de cuidados, que segmentos da população podem entrar (ou sair) dos grupos que necessitarão deste tipo de cuidados, ou mesmo antecipar a realização de campanhas de sensibilização ou de apoio preventivo a grupos que podemos prever que necessitarão dos nossos serviços.

Tendo em conta todas estas questões, e incentivados pelo contexto, podemos concluir a utilidade e os benefícios da utilização destas tecnologias no tratamento de dados, bem como a sua utilização “inegociável” perante este tipo de desafios. Isto é verdade e inegável, mas não é isento de riscos significativos que teremos de gerir.

“Hoje em dia, nada custa mais do que a informação”. - I.A. Inteligência Artificial - Steven Spielberg

“Hoje em dia, nada custa mais do que a informação”. - I.A. Inteligência Artificial - Steven Spielberg. Apesar de todas as técnicas e avanços, isso não significa que sua adoção não seja um processo isento de alguns obstáculos e custos.

A sua própria aplicação acrescenta uma nova camada que temos de ter em mente e que devemos proteger

E o facto é que, no tratamento de todos estes dados, desde a sua pura ingestão até às suas diferentes camadas de processamento e refinamento, podemos incorrer em riscos de segurança. É paradoxal quando dizemos que podemos confiar na IA precisamente para proteger a informação, mas a sua própria aplicação acrescenta uma nova camada que temos de ter em mente e que devemos proteger. E a diferentes níveis, de onde e em que plataformas confiamos e lhes transmitimos dados, porque podem, ao longo do caminho, estar a recolher informações para outros fins que não os que pretendemos.

Além disso, em cada fase do processo, podemos estar a expor um ponto de entrada para essa informação, e a abrir a porta a que os dados sejam desviados, ou mesmo manipulados, comprometendo a integridade dos resultados e as decisões que posteriormente possamos tomar com base neles. Não podemos esquecer, por mais simples (e por vezes quase mágicos) que estes processos possam parecer, que eles exigem a nossa atenção para os manter devidamente protegidos.

Na sua aplicação, podemos incorrer em novos enviesamentos algorítmicos

Riscos não só em termos de segurança, mas também em termos da própria aplicação, que pode também contribuir com ruído, semelhante (e por vezes pior) ao ruído que estamos a tentar eliminar. Na sua aplicação, podemos incorrer em novos enviesamentos algorítmicos, fazendo com que certos elementos deixem de ser elegíveis, que certos cidadãos nunca recebam um subsídio, ou que nunca detectemos uma necessidade que esteja fora do processo de aprendizagem que tínhamos inicialmente marcado. Se projectarmos a sua aplicação como “caixas negras” às quais não exigimos suficiente transparência nos seus cálculos, podemos estar a colocar um véu sobre as conclusões, que escondem atrás de si manipulações indevidas da informação, discriminações injustificadas...

Além disso, e como é óbvio, como qualquer outra tecnologia, devemos utilizar estes processos apoiados pela IA para cumprir os quadros regulamentares aplicáveis em função da natureza dos dados que estamos a tratar. É claro para todos nós que o tratamento de informação sensível, saúde, situação económica de todos nós enquanto cidadãos, família, etc., deve continuar a estar sujeito à preservação dos direitos e leis que os protegem, e na sua aplicação teremos de trabalhar para a sua preservação. Isto inclui também tanto os quadros legislativos incipientes que estão a ser gerados a este respeito, como as regras já existentes que se aplicam em geral a qualquer projeto tecnológico que trabalhe com dados.

Aplicar a tecnologia de forma equilibrada

Em todo o caso, estes riscos, convertidos em tarefas a resolver a partir de uma abordagem de resolução através de estratégias proactivas, continuam a fazer parte da aplicação da IA a projectos de tratamento de dados. Não são, portanto, um elemento que nos deva travar na sua aplicação; é simplesmente uma questão que devemos ter em conta ao implementar a IA e tirar partido de todo o poder e soluções que facilitam e tornam muito mais eficientes os nossos processos de transformação dos dados originais em informação do mais alto valor nas fases subsequentes de tomada de decisões estratégicas nos nossos processos. Estamos, portanto, a falar de aplicar a tecnologia de forma equilibrada para garantir a transparência, a segurança e a equidade, a fim de assegurar que tiramos partido de todos os seus benefícios, que são muitos, sem comprometer os aspectos éticos fundamentais e a confiança.

A aplicação da IA, um processo de implementação imparável e inevitável

Colocadas na balança, e trabalhando com estas premissas de equilíbrio, a aplicação da IA em projectos de tratamento de dados é hoje uma realidade, e um processo de implementação imparável e inevitável.

Vimos, pelo menos em parte para que nos possa contextualizar, a utilização das tecnologias associadas à família alargada que englobamos com o termo IA no tratamento de dados, numa primeira fase de ingestão e modelação de dados. Tanto o seu tratamento como os riscos e questões que temos de ter em conta na sua aplicação. Também a necessidade inerente à aplicação de qualquer tecnologia, e a IA não escapa a estas necessidades, de termos a transparência e mecanismos de controlo humano que garantam a sua qualidade e a correção dos resultados e conclusões obtidos.

Neste momento, alguns sentirão falta da sua aplicação em fases posteriores, como a geração de visualizações analíticas, a automatização de decisões estratégicas com base nos modelos gerados... E obviamente não nos esquecemos deles, dada a sua extensão e o interesse que despertam em todos nós à sua volta, o que nos levará ao próximo artigo desta série em que os desenvolveremos com o devido detalhe. "Até breve.

Com mais de 20 anos de investigação e colaboração em diferentes projetos de análise de dados. Tem uma vasta experiência em diferentes tecnologias de BI, com especial incidência na plataforma de análise Qlik.